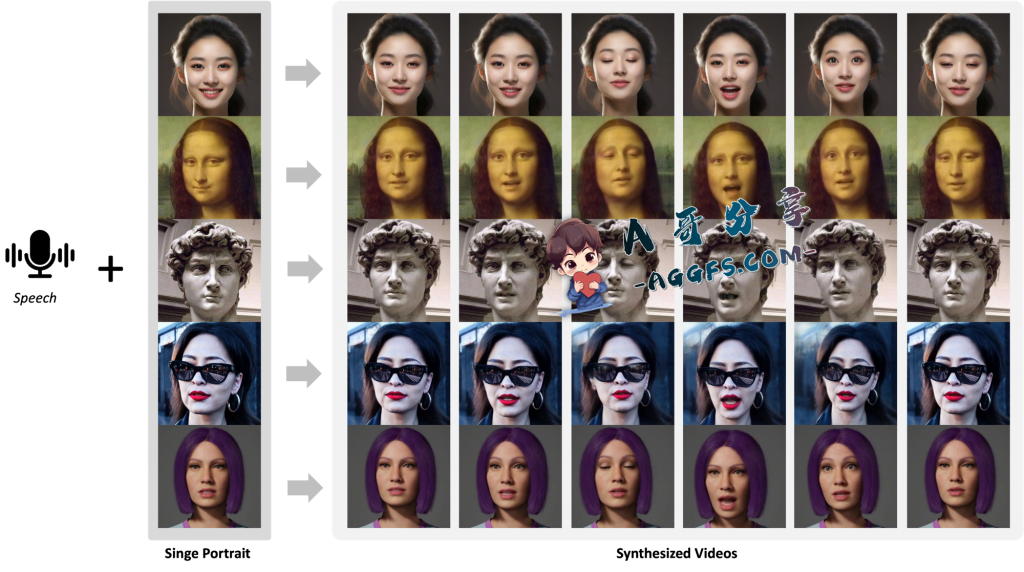

AniTalker是什么

这是一个创新框架,旨在从单个肖像中生成栩栩如生的说话面孔。现有模型主要关注唇形同步等语言线索,无法捕捉面部表情和非语言线索的复杂动态,与此不同的是,AniTalker 采用了通用的运动表示。这种创新的表现方式有效地捕捉了广泛的面部动态,包括微妙的表情和头部运动。 AniTalker 通过两种自监督学习策略增强运动描绘:第一种涉及从同一身份内的源帧重建目标视频帧以学习微妙的运动表示,第二种使用度量学习开发身份编码器,同时主动最小化身份之间的互信息和运动编码器。这种方法确保运动表示是动态的并且没有特定于身份的细节,从而显着减少对标记数据的需求。此外,扩散模型与方差适配器的集成允许生成多样化且可控的面部动画。这种方法不仅展示了 AniTalker 创建详细且真实的面部动作的能力,而且还强调了其在为现实世界应用制作动态头像方面的潜力。

AniTalker视频演示

AniTalker如何使用

演示:https://x-lance.github.io/AniTalker/

GitHub:https://github.com/X-LANCE/AniTalker

论文:https://arxiv.org/abs/2405.03121

- 转载请保留原文链接谢谢!

- 本站所有资源文章出自互联网收集整理,本站不参与制作,如果侵犯了您的合法权益,请联系本站我们会及时删除。

- 本站发布资源来源于互联网,可能存在水印或者引流等信息,请用户擦亮眼睛自行鉴别,做一个有主见和判断力的用户。

- 本站资源仅供研究、学习交流之用,若使用商业用途,请购买正版授权,否则产生的一切后果将由下载用户自行承担。

- 联系方式:[email protected]

评论(0)